Ha fatto una giravolta su sé stesso e si è buttato dalle scale. Poi ha smesso di funzionare. Protagonista della vicenda non è infatti una persona, ma un robot. La notizia è quindi che anche i robot possono suicidarsi. O almeno è questo che si ritiene essere accaduto all’inizio di luglio a un robot impiegato come funzionario amministrativo in Corea del Sud, forse “a causa di stress”.

Il fatto ci interroga sui limiti dell’artificiale, sulla computabilità delle emozioni, sull’etica relativa al mondo robotico. È stata una scelta razionale oppure una scelta emotiva? I robot non hanno o non dovrebbero avere, emozioni. In ogni caso la vicenda getta un cono d’ombra sul futuro della convivenza tra uomini e macchine. Se le macchine possano provare emozioni o se gli ingegneri siano così bravi da simulare le emozioni in un essere artificiale è domanda che ci accompagna da sempre. Ma per rispondere servono meno ingegneri e più psicologi. Capire le caratteristiche dell’umano è la vera sfida, che ci riguarda tutti.

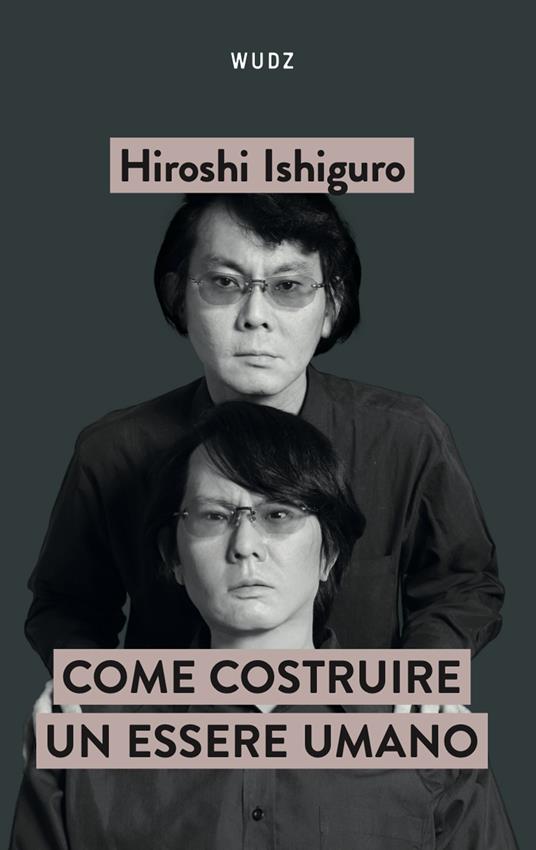

Come costruire un essere umano è il grande racconto del dottor Frankenstein del nostro tempo, Ishiguro Hiroshi, lo scienziato che sta disegnando il nostro futuro, che lo fa proprio nel saggio Come costruire un essere umano, recentemente pubblicato da Wudz Edizioni (2024). Per il luminare della robotica umanoide “costruire un androide non significa replicare punto per punto l’umano ma interrogarsi su cosa significhi essere umani”. Sono queste parole pronunciate in esergo da Ishiguro, docente di Intelligenza Artificiale all’Università di Osaka, a rappresentare la base della sua analisi. Ishiguro, più volte ospite della trasmissione di Rai1, Codice, tutta la vita è digitale, ha da poco firmato un accordo di collaborazione scientifica con il nostro Paese e nel libro racconta ai lettori il lungo viaggio in compagnia dei suoi robot umani, e come questi rivoluzioneranno per sempre il nostro modo di vivere.

Per quelli di noi che ancora legittimano la superiorità dell’umano con il possesso della coscienza, per certuni dell’anima, è difficile accettare che un essere artificiale possegga una decisionalità propria. Ma se accettiamo la logica della simulazione, quella dei comportamenti umani riprodotti in maniera artificiale e numerizzati, cioè digitalizzati attraverso sequenze di zeri e di uno, dobbiamo riconoscere in via ipotetica che si possa digitalizzare la coscienza stessa, ammesso che ci si metta d’accordo su cosa sia. In fondo è una questione di convenzioni, da cui discendono le convinzioni.

Se per convenzione, cioè in seguito a un accordo condiviso, riteniamo riproducibile l’output di un comportamento cosciente, possiamo immaginare di poter simulare la coscienza, quel modo di essere presenti a noi stessi come risultato dell’autopercezione di processi interni che, tradotti in unità discrete, possono essere riprodotti artificialmente. Per questo studiare l’umano è importante per chi realizza umanoidi innestati di intelligenza artificiale, ma anche per chi ci dovrà vivere insieme.